在电脑上本地部署R1,就可以!无需联网、不用担心数据泄露、完全免费,还可以搭建个人知识库,训练你的专属AI助理。

01

部署流程

本地部署只需要三步:

安装Ollama

下载deepseek-R1大模型

使用Cherry Studio调用模型

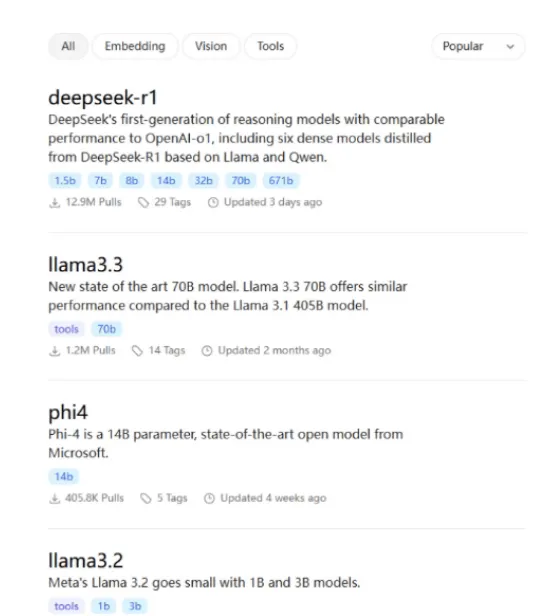

Ollama的模型库里的40多种开源模型,比如阿里云通义千问推出的大模型Qwen2.5,Meta公司最新的大模型Llama 3.3等等,都可以通过这套流程来本地部署。

操作简单,0基础有手就会,而且完全免费!

接下来我们一步一步还原一下本地部署DeepSeek-R1大模型的全过程。

02

安装Ollama

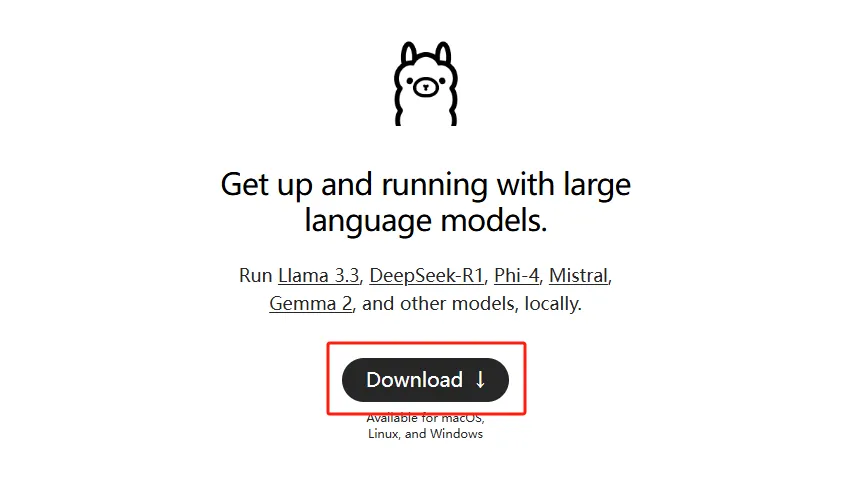

Ollama是一个在本地计算机上运行大模型的命令行工具,有了它,你就可以在本地跑大模型。

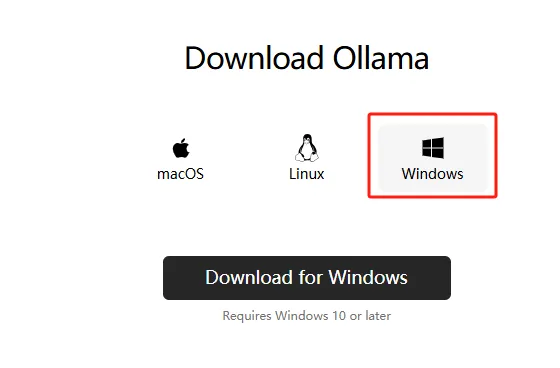

进入Ollama官网登录,点击Download。

Ollama提供三个版本的安装包,根据自己的电脑下载对应的版本。

我用的是Windows系统,所以直接选择Windows的版本下载。

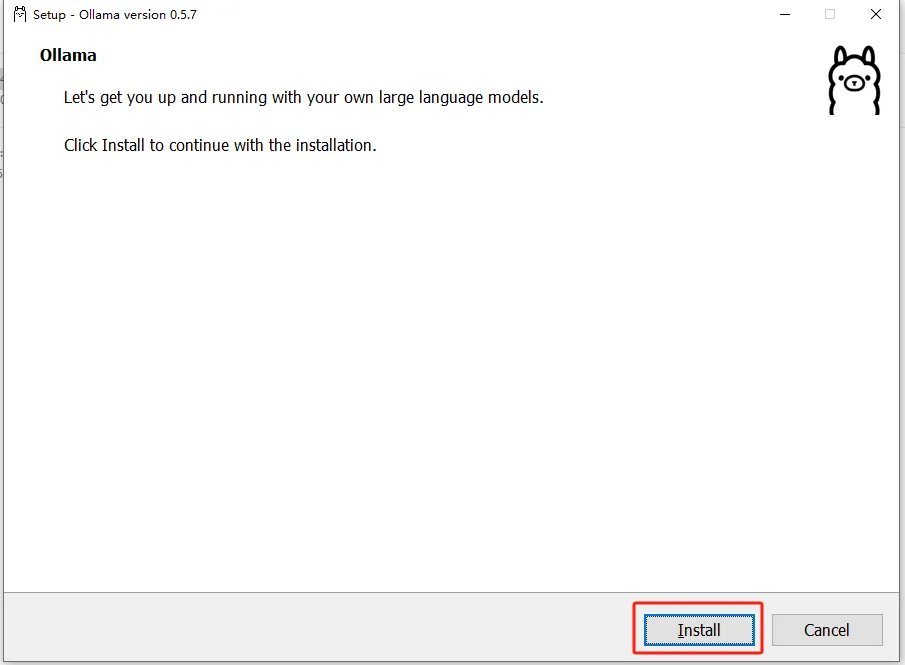

下载完点击安装,会默认安装在C盘,Windows版本不支持修改安装位置,所以我们无脑点“下一步”就行啦!

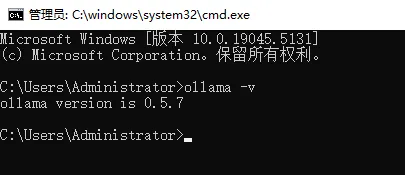

安装完成后在右下角任务栏会出现ollama的图标;可通过命令面板查看ollama的版本号;

Ollama就安装成功啦。

03

部署DeepSeek R1模型

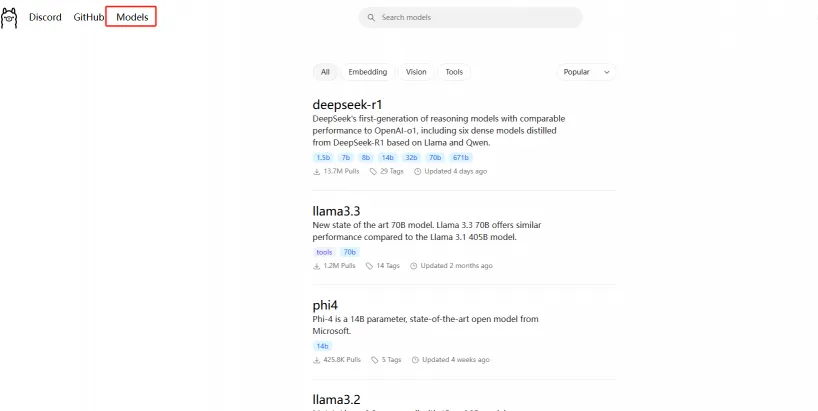

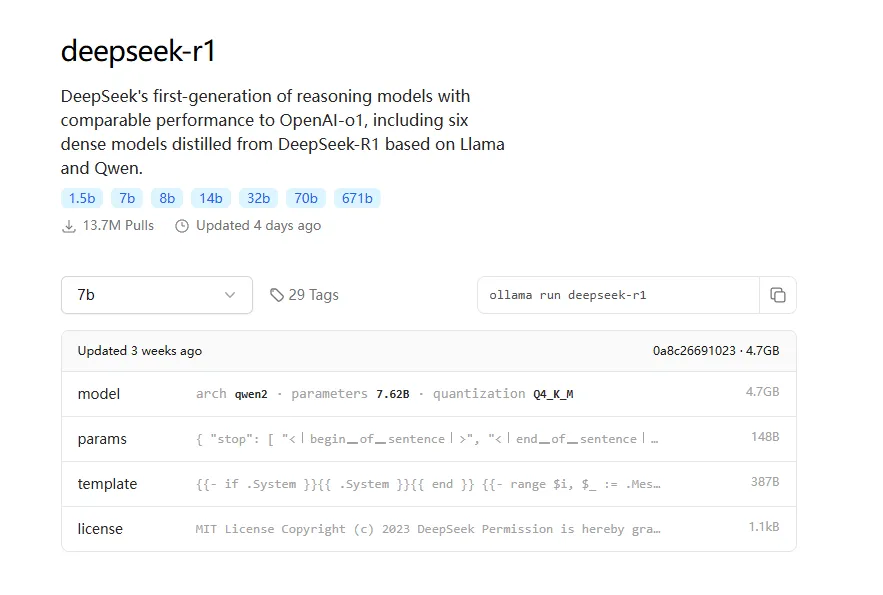

我们回到Ollama官网,点击左上角的“Models”进入模型库,点击DeepSeek-R1大模型。

Ollama提供7种不同参数的模型可供下载。

R1的模型参数是671B,差不多需要1300个G的显存,你才能跑得动满血版R1。

1.5B到70B是R1的蒸馏版,模型能力虽然不如满血版(参数数字越大能力越强),但是对硬件要求更低,在同规模的开源模型里表现也是很突出的,适合个人或企业本地部署。

我总结了一份DeepSeek-R1每个版本的配置要求的表格,大家可以对照选择:

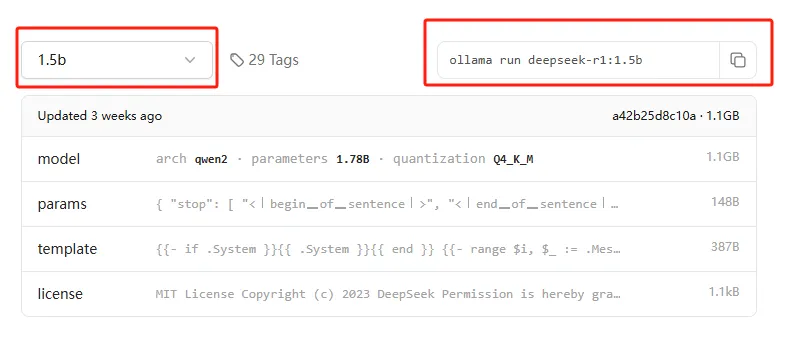

这里我选择1.5B的模型,复制后面口令:

ollama run deepseek-r1:1.5b

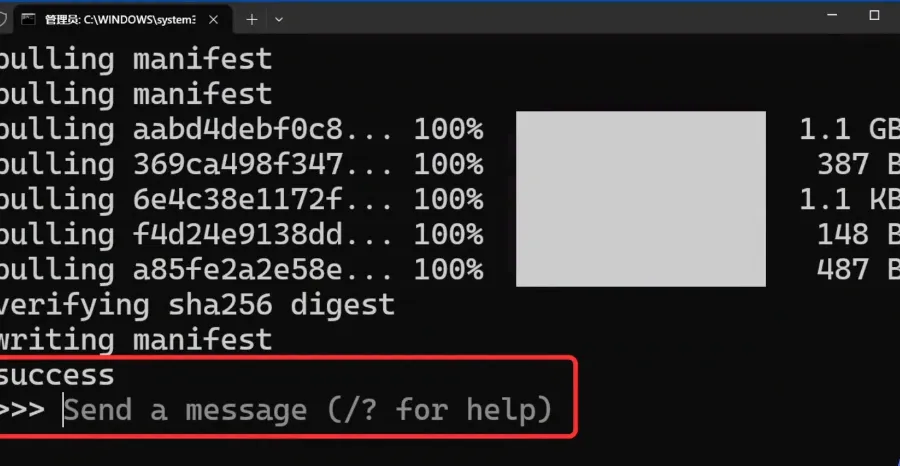

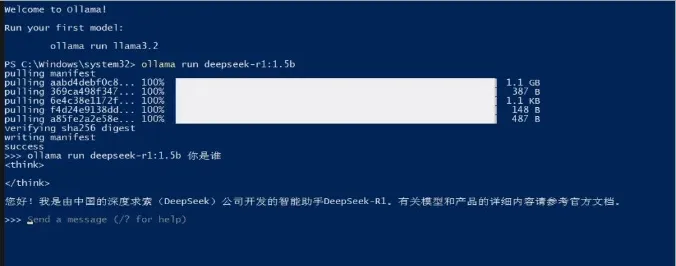

把口令粘贴进Ollama弹出的窗口中,按回车,就会开始下载模型。

静静等待进度条到100%,最后提示“success”,就说明下载完成了。

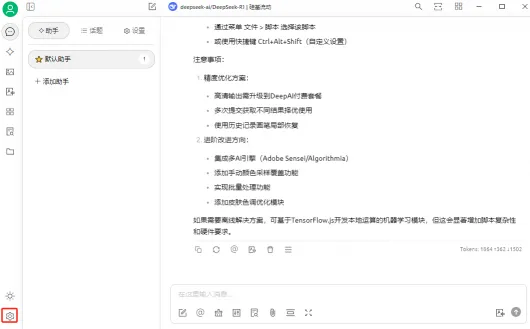

我们在命令行输入ollama run deepseek-r1:1.5b+问题,就能直接与AI对话。

但是这个界面看着太简陋了,而且每次提问都要复制一行命令,也不太方便。

接下来我们通过客户端来优化这个问题。

04

通过Cherry Studio调用模型

Cherry Studio是一款开源的多模型桌面客户端。它可以直接调用主流的大模型,比如OpenAI、Gemini,和本地模型。

像这样开源、好用的客户端还有Chaxbox AI、AnythingLLM等等。

官方也整理过一份实用集成文件,可以帮我们更好地应用DeepSeek。

这里我们以Cherry Studio为例,一起操作一下。

进入Cherry Studio官网的下载界面。

安装步骤也是直接点下一步即可。

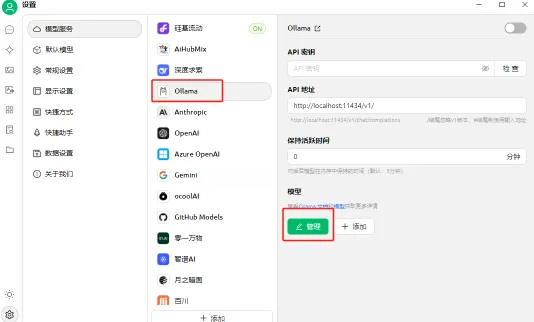

安装后点击左下角的设置。

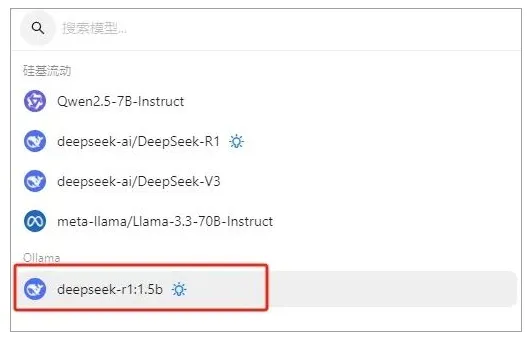

在模型服务里选择Ollama,点亮右上角的启用,API密钥会自动填写,然后点击管理。

可以看到本地已经安装好的DeepSeek-R1模型,点击右边的+号。

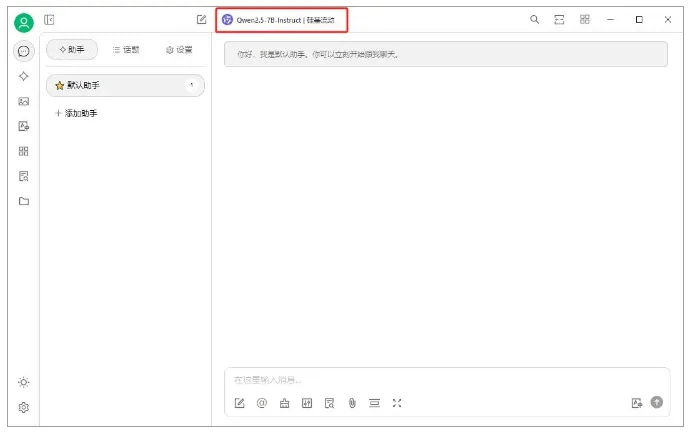

我们返回到首页,点击页面上方显示的模型名称。

点击选择我们本地部署的DeepSeek-R1:1.5B。

就可以跟AI正常对话啦。

特别声明: AI资源导航提供的DeepSeek本地部署保姆级教程,0基础有手就会!等网址链接均来源于网络或用户投稿,本站不保证其准确性和完整性,同时该外部链接的指向,不受AI资源导航的实际控制。如果链接出现违规,请直接反馈或联系网站管理员进行删除处理。