CodeFormer:AI图像修复领域的革命性突破

技术原理:重建视觉真实的底层革新

CodeFormer是由南洋理工大学与商汤科技联合研究中心S-Lab提出的革命性人脸修复模型,在2022年NeurIPS会议上发表,其核心创新在于将图像修复转化为离散编码序列预测任务。该模型通过三阶段训练架构实现突破:

- 码本学习(Stage I):利用VQGAN构建离散码本空间,通过32倍压缩比将人脸转化为紧凑编码序列,形成富含细节的视觉先验库

- 序列预测(Stage II):引入Transformer模块全局建模,取代传统最近邻匹配,显著提升退化图像的编码准确性

- 可控融合(Stage III):创新性加入可调节特征融合模块(CFT),通过权重参数平衡输出质量与身份保真度(0-1取值调节)

这种架构从根本上解决了人脸修复的三大难题:退化图像与高清图像间的多对多映射不确定性、纹理细节丢失问题以及身份一致性保持挑战。实验显示,其离散码本空间相比连续先验空间,能输出更自然的纹理且避免伪影。

功能应用:超越想象的视觉重生

| 应用场景 | 技术效果 | 典型案例 |

|---|---|---|

| 老照片修复 | 去除噪点/划痕,增强分辨率/色彩 | 民国老照片高清还原 |

| 人脸去码 | 重建马赛克区域生物特征 | 影视资料修复 |

| 视频增强 | 逐帧修复,提升分辨率(360p→720p) | 低清监控视频增强 |

| AI人脸校正 | 修复生成式AI的面部畸变 | Stable Diffusion输出优化 |

| 破损图像修复 | 重建缺失区域(遮挡/涂鸦) | 文物档案修复 |

在处理多人合影时,CodeFormer可自动识别并修复画面中所有人脸;对于单色图像,其色彩化模块能基于场景语义智能添加合理色彩。实际测试显示,即使对16×16像素的极低分辨率输入,模型仍能重建可信人脸结构。

性能优势:业界标杆的实测验证

与同类模型对比中,CodeFormer展现出显著优势:

- 质量对比:相比GFPGAN的“过度磨皮”效果,CodeFormer保留真实皮肤纹理,尤其擅长男性面部细节还原;但对女性牙齿修复仍有优化空间

- 速度基准:

- 原生PyTorch推理:512×512图像约100-120ms/帧

- TensorRT加速后:634×360图像仅55-75ms/帧(RTX 4070 Ti)

- 跨平台部署:支持ONNXRuntime引擎,提供C++/Python双版本,适配边缘设备

值得注意的是:输入清晰图像时建议跳过处理,模型对非退化图像可能产生负向优化。实践中需结合模糊检测算法实现智能触发。

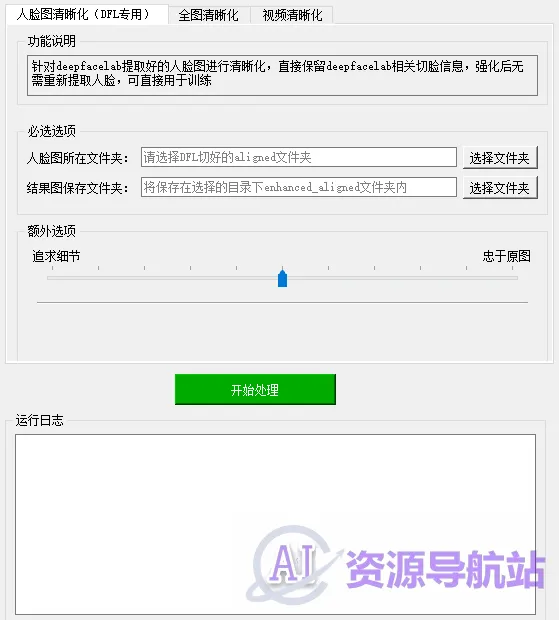

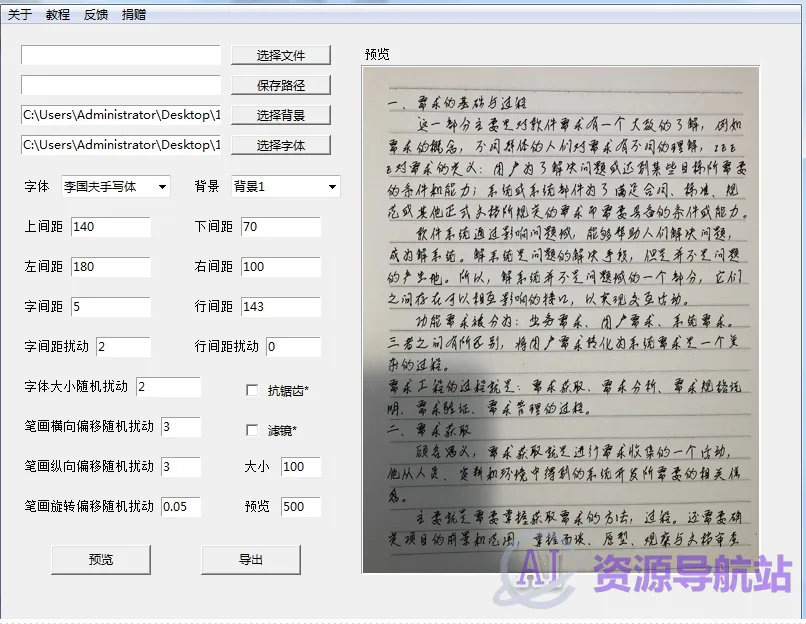

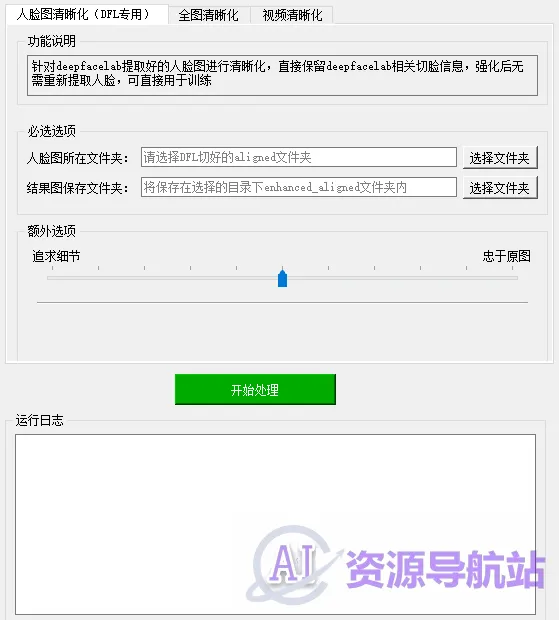

实践指南:零门槛落地方案

本地化部署:

- Windows一键版:提供2.27GB压缩包(百度网盘),解压即用,需英伟达显卡

- 开发者安装:

Bashgit clone https://github.com/sczhou/CodeFormer.gitconda create -n codeformer python=3.8 pip install -r requirements.txt python scripts/download_pretrained_models.py CodeFormer ``` [23](@ref) [59](@ref)

参数调优技巧:

- -w参数控制保真度(默认0.5):

- 低退化图像→调高值(0.8-1.0)保持原特征

- 高退化图像→调低值(0.2-0.5)提升质量

- 视频处理需转换为MP4/MOV/AVI格式,多人像修复无需预裁剪

未来展望:重塑视觉的边界

CodeFormer的技术突破超越了传统修复范畴。在文化遗产保护领域,它使破损历史照片的高精度还原成为可能;在影视工业中,为经典影片4K重制提供新思路;甚至为医学影像分析提供细节增强新路径。随着扩散模型与3D重建技术的融合(如CDFormer架构探索),其潜力将进一步释放。

正如开发者所述:“我们改变了复原任务的固有范式”。当AI能从最模糊的像素中重构真实,人类对视觉可信度的认知边界已被重新定义。CodeFormer不仅是一项技术成果,更是对人类视觉记忆的数字化救赎——让消逝的细节重获新生,让被时光掩埋的面容再度清晰。

使用注意事项:路径不可以出先中文

在根目录下创建两个文件夹一个放原图,一个放修复后的图(视频同理)

特别声明: AI资源导航提供的CodeFormer等网址链接均来源于网络或用户投稿,本站不保证其准确性和完整性,同时该外部链接的指向,不受AI资源导航的实际控制。如果链接出现违规,请直接反馈或联系网站管理员进行删除处理。